65

AI 요약

이 글은 AI가 원문을 분석하여 핵심 내용을 요약한 것입니다.

국내 최초 MoE 모델 ‘Kanana-MoE’ 개발기

이 게시물은 카카오 AI 팀에서 개발한 국내 최초 MoE(Mixture of Experts) 모델인 ‘Kanana-MoE’에 대해 소개합니다.모델 개발 배경과 구성

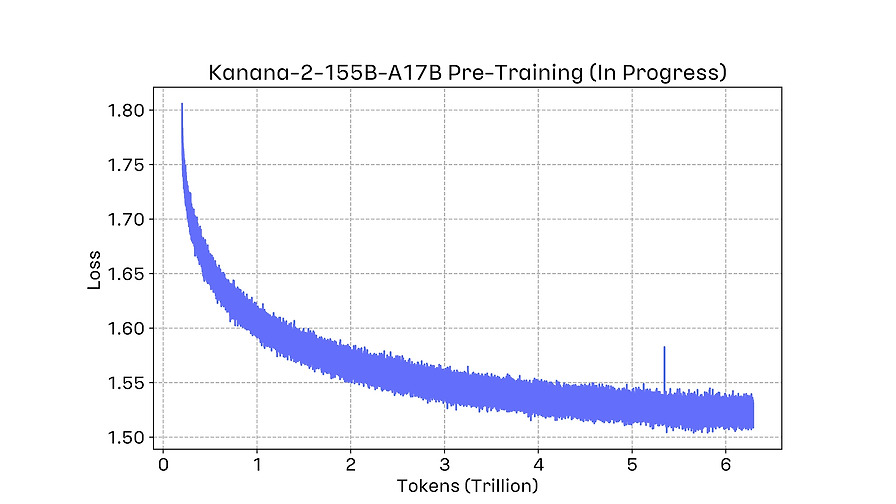

- Kanana-MoE는 대규모 언어모델의 효율성과 성능을 높이기 위한 MoE 아키텍처를 적용

- Pre-Training과 Post-Training 단계에서 각각의 연구원이 참여하여 모델을 완성

특징과 기대 효과

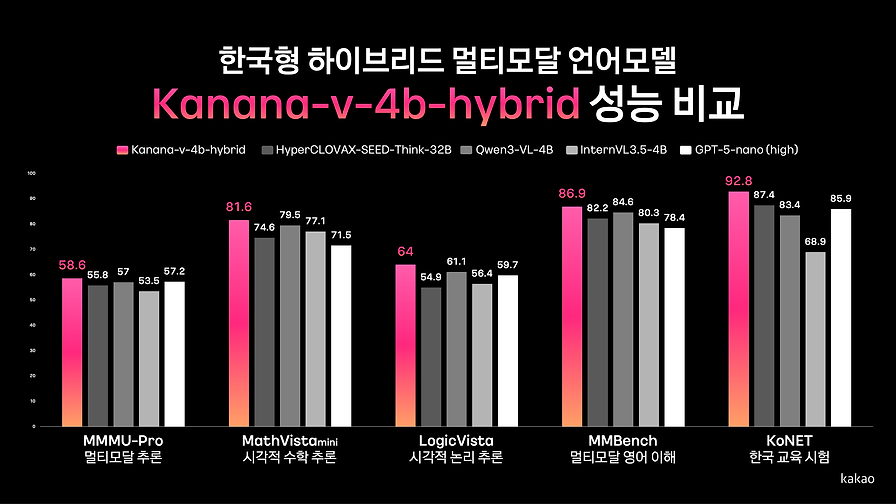

- 효율적인 파라미터 활용으로 연산 비용 절감

- 성능 향상을 위한 다양한 연구와 실험 진행